ゼロから作るDeep Learning ? ―自然言語処理編

- 作者: 斎藤康毅

- 出版社/メーカー: オライリージャパン

- 発売日: 2018/07/21

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (3件) を見る

「ゼロから作るディープラーニング②」を購入した。

あまり内容を詳細に記録するつもりはないので、読んで纏めていったものをGistに張り付けていく。

第6章はゲート付きRNNだ。シンプルなRNNでは学習の効率が良くないところを、ゲート付きのRNN(いわゆるLSTMなど)を使って効率化していく。

- 6章 ゲート付きRNN

6.6 まとめ

- 単純なRNNの勾配喪失・勾配爆発の問題を解決するために、以下のテクニックを導入する。

- 勾配クリッピング

- LSTM/GRUなどのゲート付きRNN

- LSTMに使用されるゲート

- inputゲート

- forgetゲート

- outputゲート

- それぞれに重みがついている。sigmoid関数で0.0から1.0までの値が使われる。

- 言語モデルの実装

- LSTMレイヤの多層化

- Dropout

- 重み共有

- RNNの正則化は重要なテーマであり、Dropoutベースの様々な手法が提案されている。

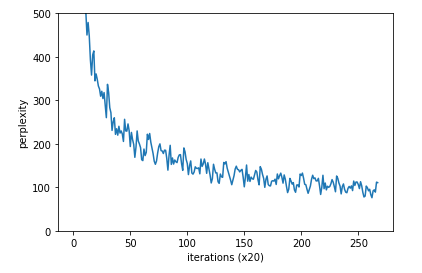

図. ゲート付きRNNの実行結果。